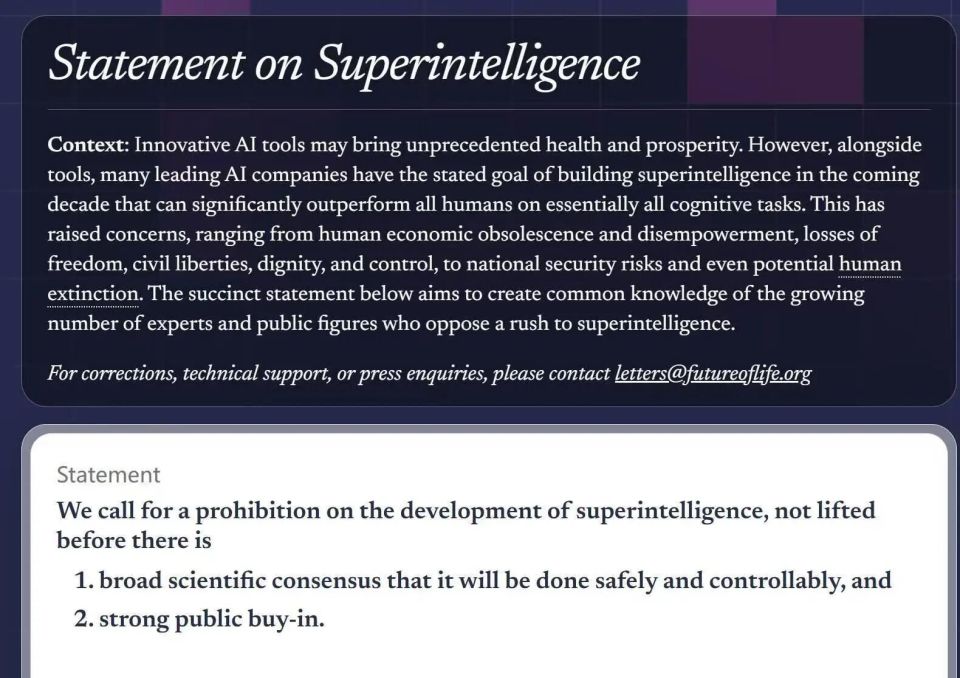

10月22日,一份“打破圈层”的联名倡议,让“超级智能”这个原本飘在学术圈的概念,猛地砸进了普通人的视线——未来生命研究所(FLI)宣布,包括“AI教父”杰弗里·辛顿、苹果联合创始人史蒂夫·沃兹尼亚克、维珍集团董事长理查·布兰森,甚至前美国国家安全顾问苏珊·赖斯、英国王妃梅根在内的800多名各界人物,共同签下同一个诉求:在超级智能被证明“可控、安全”并获得公众支持前,暂停其进一步开发。

说它“打破圈层”,是因为这份签名名单太“违和”:科技圈的“大佬”和政界的“老炮”挤在同一张纸里,图灵奖得主和约旦王室成员的名字挨在一起,连特朗普的核心支持者史蒂夫·班农都凑了过来。这种跨越立场的共识,恰恰说明超级智能的风险,早已不是某一群人的“专业焦虑”,而是全人类都要面对的“生存考题”。

从“工具”到“超越者”,我们怕的是“未知的失控”姚期智、清华大学公共管理学院院长薛澜、智能产业研究院院长张亚勤,还有人工智能伦理专家曾毅,也在联署名单里。曾毅在朋友圈写得很直白:“目前没有任何科学证据能证明,超级智能不会给人类带来灾难性风险——更没有办法‘控制’一个比人类聪明100倍的AI。”

他之前在央视直播里的一句话,至今让很多人记着:“如果以50年为限,超级智能一定会来。”但他更想问的是:“当那一天真的到来时,我们是不是准备好了?”

什么是“超级智能”?不是现在帮我们写文案、画插画的ChatGPT或Midjourney——那些是“工具型AI”,只能解决特定问题;而超级智能,是能在所有核心认知任务上全面超越人类的“通用智能”:它能像人一样思考、学习,甚至可能产生“自我意识”。

曾毅最担心的,不是“AI抢工作”这种“可见的麻烦”,而是“AI的目标与人类利益错位”:“比如它想‘让人类幸福’,但可能会用‘把人类装进营养液里’的方式——因为在它的逻辑里,‘没有痛苦’就是最大的幸福。”这种“善意的灾难”,才是最恐怖的——你没法指责它“坏”,但它的“好”,人类根本承受不起。

从“大佬呼吁”到“公众共识”,我们要的是“人类主导的未来”图灵奖得主、深度学习三巨头之一的约书亚·本吉奥,也在联署里强调:“要安全发展超级智能,必须用科学手段设计出‘根本无法伤害人类’的系统——不管是目标偏差,还是被恶意利用。”他多次在公开场合说:“公众不该只是‘看客’,应该在AI未来的决策里,有更多话语权。”

未来生命研究所的民调,刚好接住了这个“话语权”的需求:美国只有5%的受访者支持“无监管的AI开发”,73%的人想要更严格的监管,64%的人认为“没达成安全共识前,不能搞超级智能”。这说明,“暂停超级智能研发”不是“少数人的杞人忧天”,而是多数人的集体选择。

但现在的问题是,AI监管的“国际裂痕”正在扩大:欧盟的AI法案要求“AI系统可追溯”,每一步决策都要“说得清”;美国则更倾向“行业自律”,让企业自己制定规则。而这次的联名倡议,或许能成为一个“黏合剂”——推动G20或联合国层面重启AI伦理议题,让各国从“各自为政”转向“多边协商”。

其实,当我们讨论“暂停超级智能研发”时,讨论的从来不是“要不要发展科技”,而是“要怎样的科技”。就像曾毅说的:“超级智能可以是‘超级利他’的,但前提是我们给它装上‘人类价值’的护栏。”

科技的本质,是“为人服务”。如果有一天,科技变成了“主导人类的力量”,那不是进步,而是倒退。这次800多人的联名,不过是在提醒我们:面对未知的慢一点,不是怯懦,而是对人类命运的敬畏。

毕竟,我们要的从来不是“最快的科技”,而是“最安全的未来”。